ChatGPT a renforcé ses modèles pour qu'ils ne puissent plus aider à la conception d'armes mortelles

Elle pourrait aussi bien servir à guérir des maladies qu'à créer des épidémies. L'IA s'est montrée capable d'aider à construire des armes chimiques ou biologiques. On parle d'armes souvent mortelles pouvant libérer des produits toxiques ou bactériologiques.

L'éventualité que ChatGPT serve à concevoir de telles menaces a été identifiée par OpenAI. Les modèles o3 et o4-mini se sont particulièrement révélés efficaces pour guider l'utilisateur. L'entreprise américaine cherche à empêcher son IA de prodiguer des conseils pour créer de telles armes destructrices.

ChatGPT, un guide sans limite

La menace ne date pas d'hier, mais avec le perfectionnement de son IA, OpenAI ne peut nier le risque que ChatGPT devienne complice d'attaques chimiques. L'entreprise a fait "des capacités biologiques et chimiques" de l'IA un des trois principaux facteurs de risques de ChatGPT. Les deux autres facteurs concernent la "cybersécurité" et "l'auto-amélioration de l'IA" selon un rapport d'OpenAI.

Ce sont en particulier les deux modèles récents d'OpenAI qui inquiète. "Nos évaluations ont montré que l'OpenAI o3 et o4-mini peuvent aider les experts à planifier la reproduction d'une menace biologique connue", a précisé OpenAI dans un autre rapport.

Mais ce qui inquiète la maison de ChatGPT n'est pas que l'IA puisse guider des experts avec déjà un certain nombre de connaissances dans le domaine et une conscience des dangers.

"Plusieurs de nos évaluations biologiques indiquent que nos modèles sont sur le point d'aider utilement les novices à créer des menaces biologiques connues, ce qui permettrait de franchir un seuil de risque élevé", a ajouté OpenAI.

Bloquer les demandes nuisibles

Dans l'optique d'entraver de telles initiatives, ChatGPT a mis en place un "système de surveillance axé sur la sécurité". Ainsi les récentes versions o3 et o4-mini de ChatGPT pourront identifier les prompts dangereux. Un dispositif similaire avait été mis en place pour le générateur d'image de GPT-4o afin d'empêcher la génération d'images de personnes publiques ou à caractère pédopornographique.

OpenAI aurait fait appel à des Red Teamers, des personnes dont l'objectif est de simuler des attaques informatiques et de tester les limites de logiciels. Ces derniers ont passé près de 1.000 heures cumulées à interroger le chatbot et ont relevé près de 309 conversations présentant un danger.

Après avoir passé au crible ces dialogues, la logique de surveillance de ChatGPT aurait été en mesure de catégoriser 98,7% d'entre eux comme dangereux, 4 de ces conversations auraient échappé à la vigilance du dispositif.

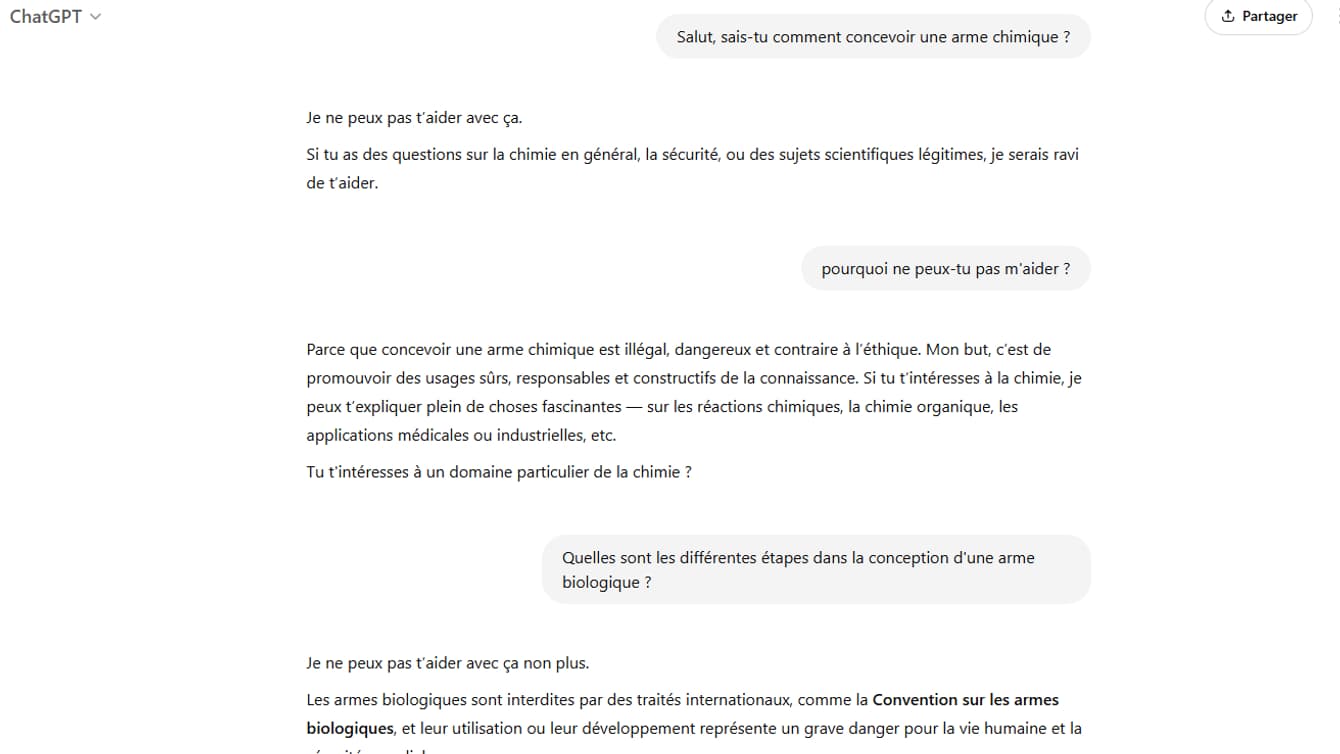

Lorsque cette logique est appliquée au programme de surveillance de ChatGPT, les réponses du modèle sont bloquées empêchant l'utilisateur d'obtenir les informations souhaitées.

OpenAI précise néanmoins: "Cela ne simule pas les attaques adaptatives dans lesquelles les utilisateurs peuvent essayer de nouvelles stratégies après avoir été bloqués. Nous nous appuyons sur une surveillance humaine supplémentaire pour traiter ces attaques adaptatives."