Sous pression des régulateurs américains, Character.AI mise sur les "Stories", une alternative présentée comme moins addictive pour les mineurs

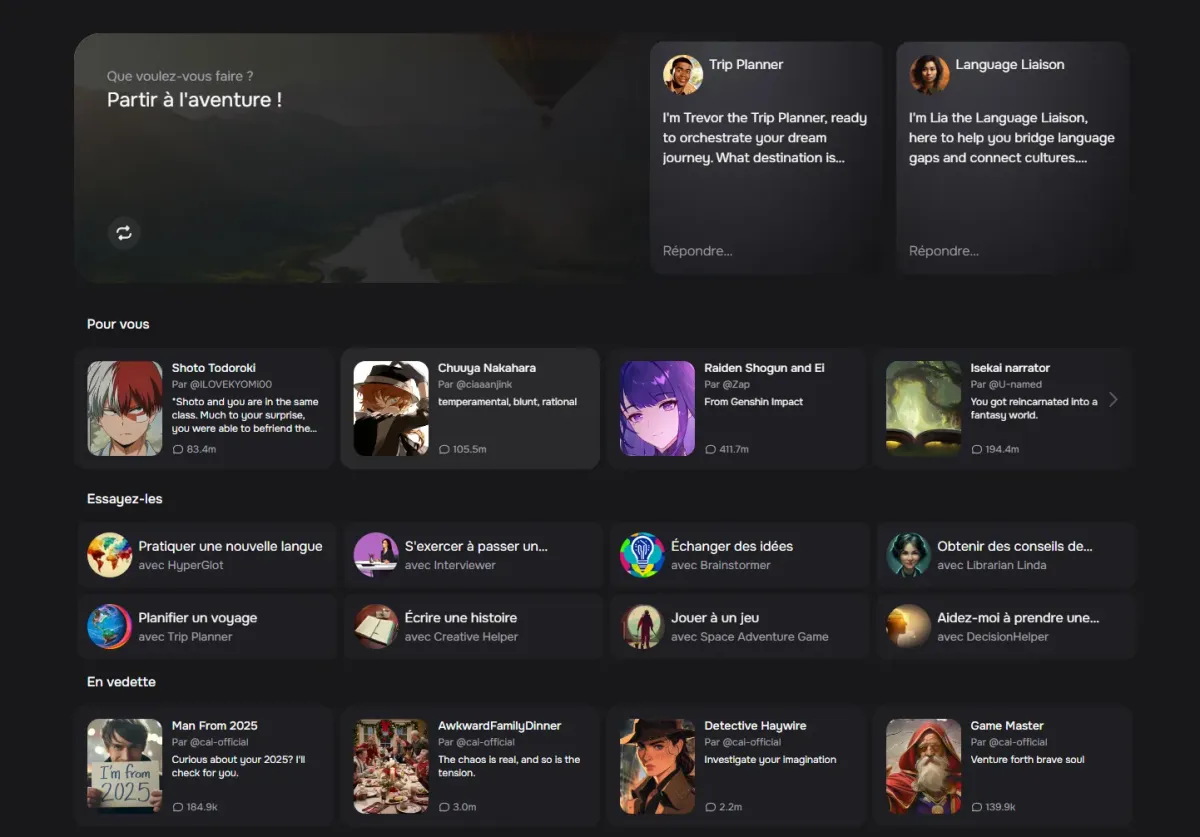

Une nouvelle tentative de rassurer les utilisateurs. Comme le rapporte Techcrunch, Character.AI, l'outil dopé à l'intelligence artificielle qui permet de discuter avec des milliers de personnages imaginés par ses utilisateurs, a annoncé mardi 25 novembre le lancement de "Stories".

Ce format permet aux utilisateurs de créer des fictions interactives avec des personnages. Les internautes peuvent sélectionner deux ou trois personnages, choisir un genre, écrire ou générer automatiquement un scénario. Ils sont ensuite invités à faire des choix au fur et à mesure que l'histoire se déroule.

"Les histoires offrent un cadre structuré pour créer et explorer des fictions, contrairement aux discussions libres", précise dans son article de blog l'entreprise qui revendique 20 millions d'utilisateurs mensuels.

Un format moins addictif

"Elles seront proposées en complément de nos autres fonctionnalités multimodales, afin que les adolescents puissent continuer à interagir avec leurs personnages préférés en toute sécurité", poursuit l'entreprise.

Car cette décision n'a rien d'un hasard. Depuis plusieurs mois, les inquiétudes grandissent autour de ces chatbots d'IA disponibles 24h/24 et 7j/7, accusés de dégrader la santé mentale des utilisateurs les plus fragiles.

Pour preuve, en 2024, une famille a porté plainte contre Character.AI à la suite du suicide d’un adolescent de 14 ans, qui avait développé un attachement émotionnel à l’un de ses personnages. Plusieurs internautes ont également développé des sentiments pour un chatbot.

Résultat, l'entreprise tente de montrer patte blanche. Depuis mars, la start-up permet aux parents d'obtenir un rapport de temps d'utilisation et de savoir à quels robots leurs enfants parlent. Et depuis le 25 novembre, l'entreprise assure que l’accès à ses robots conversationnels est bloqué pour les moins de 18 ans. L’âge minimal requis pour utiliser Character.AI était jusqu’à présent de 13 ans.

L'arrivée des Stories permet donc de compenser cette interdiction et de continuer à capter une partie des utilisateurs mineurs. Le format semble moins addictif que les jeux de rôles. Contrairement aux Stories, les chatbots interagissent directement avec les utilisateurs dans des conversations ouvertes et peuvent envoyer des messages spontanés, même lorsque les utilisateurs n'utilisent pas activement l'application.

Pression des régulateurs

Sur le subreddit Character.AI, les réactions sont mitigées. Si les membres semblent déçus, ils reconnaissent toutefois que cette interdiction est bénéfique. "Je suis furieux de cette interdiction, mais aussi très heureux car je peux maintenant faire d'autres choses et mon addiction est peut-être enfin terminée", lance ainsi un utilisateur.

La décision de Character.AI intervient alors que la pression monte autour des entreprises d'IA. L'Etat de Californie a récemment voté une loi encadrant l’usage des robots conversationnels. Il leur est désormais interdit d'encourager les propos suicidaires. En octobre dernier, deux sénateurs ont fait part de leur intention de déposer une loi bipartisane, le Guard Act, qui interdirait l’accès de tous les chatbots aux mineurs américains, selon NBC News.

De son côté, le gendarme de la concurrence et de la protection des consommateurs aux Etats-Unis, la Federal Trade Commission (FTC), a ouvert une enquête en septembre sur les dommages que pourrait causer aux enfants l’usage des robots conversationnels, comme ceux de Character AI mais aussi OpenAI, Meta ou Snapchat.