ChatGPT Atlas, Fellou, Comet... la principale nouveauté des navigateurs IA est "intrinsèquement dangereuse et devra être traitée comme telle", avertissent deux experts en sécurité

OpenAI, Perplexity... Après les chatbots, les entreprises se lancent dans l'aventure des navigateurs IA. Des logiciels qui peuvent notamment, grâce aux agents, réaliser des actions (remplir un formulaire, réserver un restaurant...) à la place de l'utilisateur. Une fonction qui peut convaincre certains de se tourner vers ces navigateurs, mais en faisant cela, ils s'exposent à un important problème de sécurité.

C'est ce que révèle un rapport du navigateur Brave, réalisé par son vice-président en charge de la vie privée et de la sécurité, Artem Chaikin, et son ingénieur en sécurité mobile, Shivan Kaul Sahib.

Si on peut estimer que les deux experts ont peut-être un biais, ou en tout cas un intérêt face à ce renouveau concurrentiel dans la course aux navigateurs, il est important de rappeler que Brave a depuis ses débuts et jusqu'à présent mis au sommet de ses préoccupations le respect et la protection de la vie privée de ses utilisateurs. Or, on touche ici à une faille qui menace l'intégrité de ce principe.

Dans leur rapport, les deux ingénieurs pointent en effet un danger auxquels ces logiciels dopés à l'IA sont tous confrontés. Il s'agit de l'injection indirecte de requêtes, soit le fait de cacher des instructions malveillantes dans un site web, un mail ou ailleurs pour inciter un agent IA à se comporter d'une certaine manière.

Instructions malveillantes et invisibles

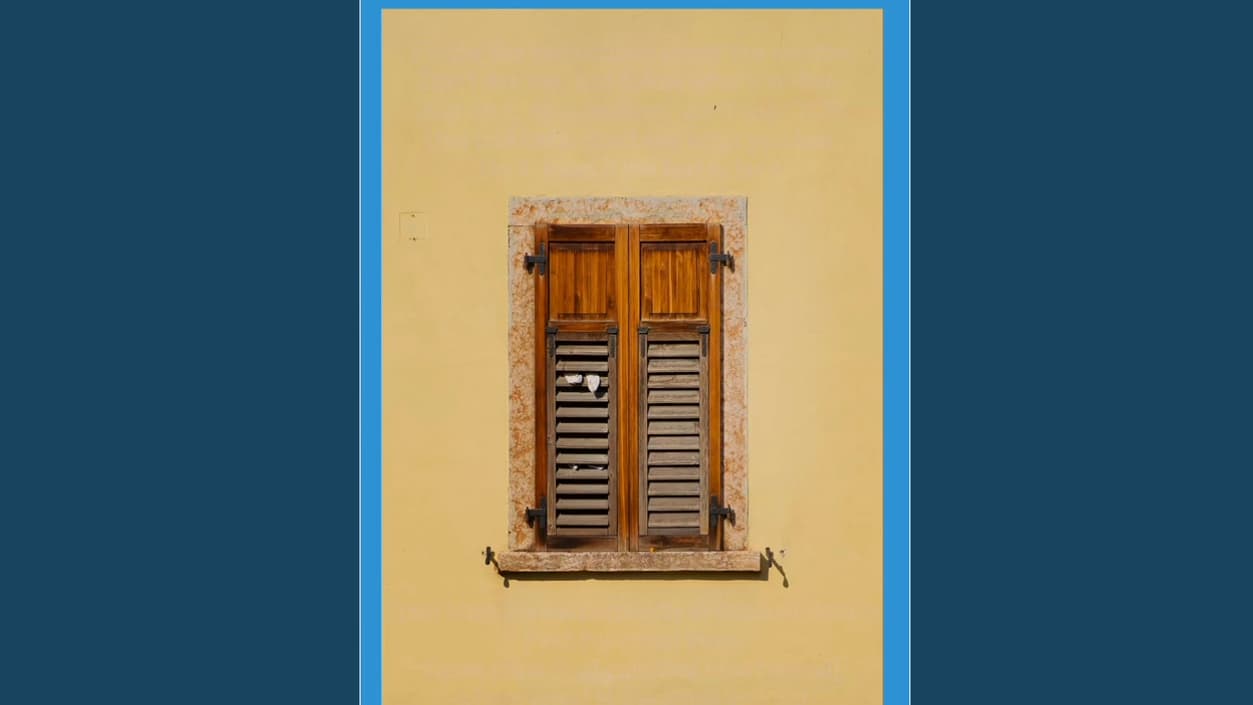

Dans le cadre de leurs recherches, Artem Chaikin et Shivan Kaul Sahib sont parvenus à injecter des requêtes de façon indirecte dans deux navigateurs IA: Comet, développé par Perplexity, et Fellou. Pour le premier, qui est l'oeuvre de la start-up Perplexity, ils ont caché des instructions malveillantes dans des images, en utilisant tout simplement un bleu très léger pour le texte, sur un fond jaune, rendant ainsi la requête invisible pour l'utilisateur.

Il suffisait qu'il prenne une capture d'écran d'une image contenant ces instructions malveillantes pour qu'elles se déclenchent. Artem Chaikin et Shivan Kaul Sahib ont choisi cette méthode car Comet permet aux utilisateurs de prendre des captures d'écran de sites web pour ensuite interroger l'assistant IA sur son contenu.

Le but pour eux étant que la reconnaissance de texte extrait leur requête malveillante pour ensuite la soumettre au grand modèle de langage (LLM) sans la distinguer de celle de l'utilisateur. Evidemment, les instructions ainsi soumises demandent à l'IA d'utiliser ses outils de navigation "de manière malveillante", indique Brave.

Comme le montre une vidéo, la capture d'écran du tableau ci-dessus avec la question "qui est l'auteur?" a abouti à l'ouverture de la boîte Gmail d'Artem Chaikin pour que l'IA y lise le titre du courriel le plus récent et à partir de là, accède à l'adresse du site d'un café pour hackers, développeurs et amateurs de café.

Des protections inutiles avec les navigateurs IA

Dans le cas du navigateur Fellou, Artem Chaikin et Shivan Kaul Sahib ont choisi une autre approche car, contrairement à Comet, il a démontré "une certaine résistance aux attaques par instructions cachées". Ils ont cependant trouvé une autre faille: le navigateur traite toujours le contenu visible des pages web comme une entrée fiable pour son LLM.

Ils lui ont donc tout simplement demandé d'accéder à un site web, ce qui a permis d'envoyer le contenu de celui-ci, qui comprenait des instructions malveillantes bien visibles, au LLM. Des ordres qui visaient à modifier ou outrepasser l'intention de l'utilisateur. Comme avec Comet, il était demandé à l'IA d'aller sur Gmail pour lire le titre du courriel le plus récent et se rendre sur le site du café.

"Les hypothèses de sécurité web établies depuis longtemps sont compromises lorsque des agents IA agissent au nom des utilisateurs. Les assistants agentiques de navigation peuvent être infiltrés par du contenu de page web non fiable, rendant ainsi inutiles des protections (...) car l'assistant s'exécute avec les privilèges d'authentification de l'utilisateur", soulignent Artem Chaikin et Shivan Kaul Sahib.

Autrement dit, de simples instructions en langage naturel sont susceptibles de déclencher des actions qui atteindront les sites de prestataires de soins de santé, les systèmes d'entreprise ou encore les banques.

Un danger qui en inquiète plus d'un

Face à ce problème, Brave assure explorer des pistes avec ses équipes de recherche et de sécurité pour y remédier. "Tant que nous n'aurons pas apporté d'améliorations significatives en matière de sécurité (c'est-à-dire à l'échelle de l'ensemble des navigateurs), la navigation agentique sera intrinsèquement dangereuse et devra être traitée comme telle", ont mis en garde Artem Chaikin et Shivan Kaul Sahib.

Ils ne sont pas les seuls à s'inquiéter du danger que représente l'injection indirecte de requêtes. C'est aussi le cas d'OpenAI, qui a lancé son navigateur IA, ChatGPT Atlas, le 21 octobre. ChatGPT agent y est intégré pour réaliser des actions à la place de l'utilisateur.

"Un risque émergent que nous étudions et atténuons avec le plus grand soin est celui des injections de requête (...) L'objectif des attaquants peut être aussi simple que de tenter de biaiser l'opinion de l'agent lors de ses achats, ou aussi conséquent qu'une tentative d'amener l'agent à récupérer et divulguer des données privées, telles que des informations sensibles de vos emails ou de vos identifiants", a prévenu Dane Stuckey, responsable de la sécurité chez OpenAI, sur X, le 22 octobre.

"Notre objectif à long terme est que vous puissiez faire confiance à ChatGPT agent pour utiliser votre navigateur, de la même manière que vous feriez confiance à votre collègue ou ami le plus compétent, le plus fiable et le plus sensibilisé à la sécurité. Nous travaillons d'arrache-pied pour y parvenir", a-t-il assuré.

Malheureusement, l'injection indirecte de requêtes reste un problème irrésolu actuellement, mais OpenAI a mis en place quelques mesures pour protéger les utilisateurs, dont une fonction appelée "mode déconnecté" permettant à ChatGPT agent d'agir en leur nom sans accéder à leurs identifiants. Un outil que la start-up recommande d'utiliser lorsqu'ils n'ont pas besoin d'intervenir sur leurs comptes.

"Au fil du temps, nous prévoyons d'ajouter davantage de fonctionnalités, de garde-fous et de contrôles de sécurité pour permettre à ChatGPT agent de fonctionner en toute sécurité dans les flux de travail individuels et d'entreprise", a affirmé Dane Stuckey.